De qué va esto

Entre 2022 y 2024 trabajé en una startup/productora donde investigué cómo integrar las primeras herramientas de inteligencia artificial en flujos reales de diseño y producción audiovisual.

El objetivo no era generar imágenes “bonitas”, sino mantener control visual, coherencia y criterio dentro de procesos tradicionalmente artesanales.

Durante ese tiempo documenté metodologías, pruebas y resultados, y complementé la práctica con lectura de papers técnicos en inglés para entender qué estaba ocurriendo realmente a nivel de modelo, entrenamiento y limitaciones. No me interesaba usar la herramienta por moda, sino comprenderla.

Aquí muestro pruebas, exploraciones y piezas desarrolladas con IA, combinadas con métodos clásicos de diseño, animación y composición.

Más abajo hay trabajos recientes (2024–2026), tanto comerciales como personales, donde estas metodologías ya forman parte natural del proceso.

Este fué el primer video comercial que hice. Proyecto de 2022. Una pieza que combina creatividad, inteligencia artificial, composición, edición y sonido. La idea base fue de Diego Flores. A partir de ahí desarrollé el resto del proceso creativo y técnico.

El sonido final es de Pedro Bataller (realicé una demo previa).

El copy es de Daniel Fondón. Resulta llamativo cómo ha evolucionado la IA en apenas 4 años.

Pruebas de coherencia visual con MidJourney

Estas imágenes no son prompts sueltos ni pruebas aisladas.

Forman parte de una investigación para forzar coherencia visual entre imágenes generadas con IA, de manera que pudieran leerse como planos de un mismo proyecto.

El trabajo se centró en repetir decisiones de dirección de arte —paleta, iluminación, encuadre, escala y atmósfera— y ajustar los prompts hasta que la IA dejara de improvisar y empezara a obedecer.

La idea no era sorprender, sino controlar.

Estas pruebas sentaron la base para integrar MidJourney dentro de procesos reales de diseño y producción, donde la consistencia visual es tan importante como la imagen en sí.

Aquí la intención no era construir un proyecto homogéneo, sino investigar dirección de arte, tipos de iluminación, construcción de personajes, géneros visuales y temáticas diversas.

Fue un laboratorio de estilo: probar registros, tensar los prompts, entender hasta dónde llegaba el modelo y dónde empezaban sus restricciones.

Aplicación en producción real (2024–presente)

Desde 2024, primero en Serena y actualmente en Jacaranda, estas metodologías han pasado de la investigación a la producción real.

La IA deja de ser un entorno de prueba y se integra como una herramienta más dentro de flujos profesionales de diseño, motion y postproducción, conviviendo con procesos tradicionales y decisiones de dirección creativa.

En esta etapa, el foco está en aplicar lo aprendido a contextos reales:

tiempos ajustados, equipos diversos, clientes, cambios de última hora y entregables concretos.

Las imágenes y piezas que aparecen aquí forman parte de proyectos desarrollados en producción, donde la IA se utiliza con criterio, control y responsabilidad, al servicio del lenguaje visual y no como fin en sí misma.

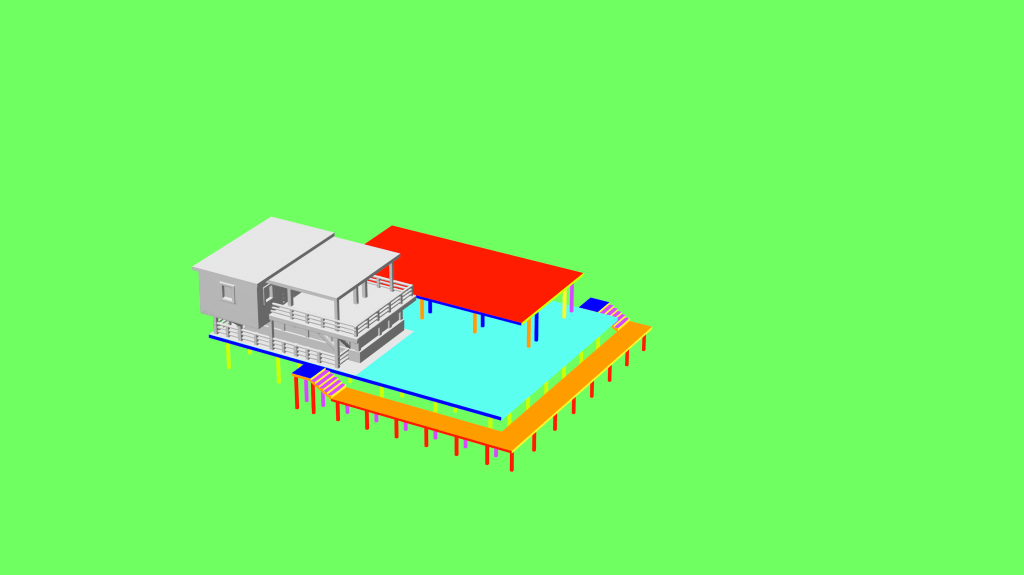

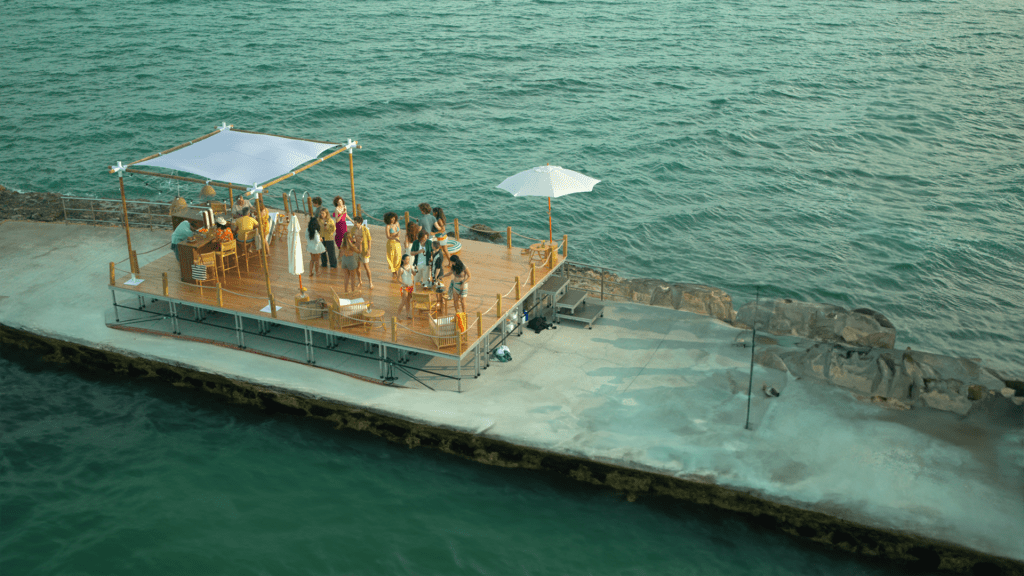

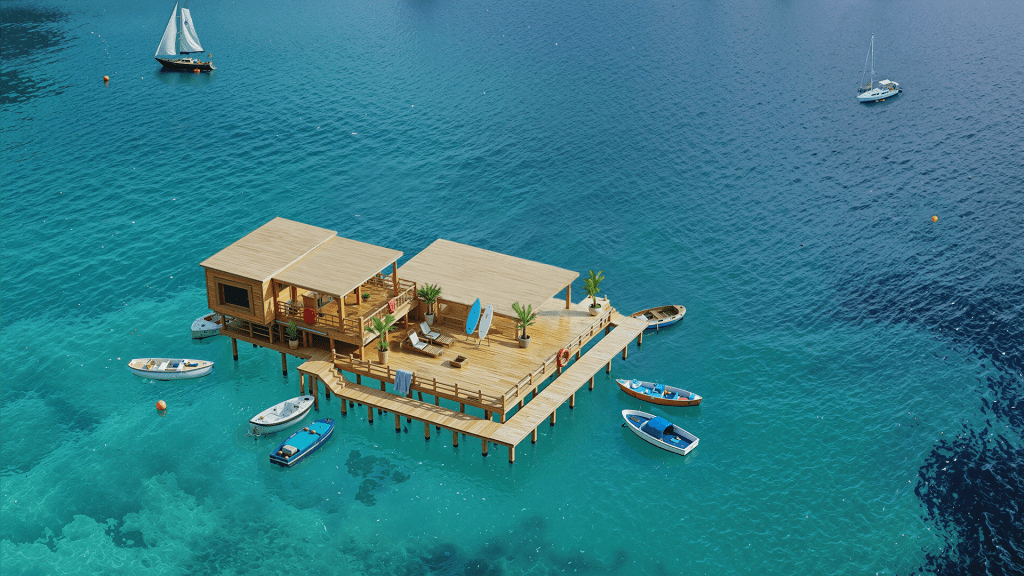

Mahou-Concept, generación y composición (Julio de 2025). Proyecto desarrollado a partir de material rodado en un entorno con limitaciones claras de producción.

La pieza partía de un único plano grabado en una plataforma asfaltada, que en el resultado final debía leerse como una estructura situada en medio del mar, rodeada de agua y con embarcaciones flotando alrededor. Además, la plataforma original resultaba visualmente demasiado pequeña y necesitaba ampliarse de forma creíble. Usé Cinema4D para crear el blueprint, luego Firefl para la construcción de la estructura base, porque es el que mejor sigue al blueprint y luego Photoshop y Topaz bloom para integrarlo con la imagen real. Finalmente animé todo con Firefly.

Abuelas (Agosto de 2025) es una pieza audiovisual creada como exploración creativa con inteligencia artificial generativa.

El proyecto investiga la relación entre control y azar en procesos creativos híbridos, combinando generación mediante IA con decisiones manuales de edición, animación y ritmo.

Patiele — Videoclip (Work in Progress). Octubre de 2025

Proyecto audiovisual en desarrollo que explora la integración de inteligencia artificial generativa dentro de un proceso narrativo musical. Mezclando la IA de las plataformas comerciales para los stills pero usando ComfyUI tanto para la generación masiva de videos como para la mejora de texturas, o el uso de Loras de personaje y estilo en los mismos.

La pieza se está construyendo desde una lógica de animación tradicional: diseño previo de personajes, assets y escenarios, definición de atmósfera y construcción de una animática sincronizada con la música antes de generar los planos finales.

El objetivo no es producir imágenes aisladas, sino mantener coherencia estética y control narrativo dentro de un entorno generativo.

Este espacio muestra parte del proceso: pruebas visuales, decisiones de dirección de arte y que darán forma a la pieza final.

Aquí dejo un doc de tratamiento visual de todo el video. En cuanto lo tenga listo dejaŕé el guión, desglose de planos, .csv con prompts…